Nvidia cho biết phần mềm mã nguồn mở TensorRT-LL mới của họ có thể tăng hiệu suất đáng kể của các mô hình ngôn ngữ lớn (LLM) trên GPU của họ. Theo công ty, khả năng của TensorRT-LL của Nvidia cho phép họ tăng hiệu suất của GPU H100 của họ lên hai lần trong LLM GPT-J với sáu tỷ tham số. Quan trọng là phần mềm có thể cho phép cải thiện hiệu suất này mà không cần đào tạo lại mô hình.

Nvidia đã phát triển TensorRT-LL specifically để tăng tốc hiệu suất của LLM inference và biểu đồ hiệu suất do Nvidia cung cấp thực sự cho thấy tốc độ tăng 2 lần cho H100 của họ do tối ưu hóa phần mềm phù hợp. Một tính năng nổi bật của TensorRT-LL của Nvidia là kỹ thuật phân tích cú pháp đang bay của nó. Phương pháp này giải quyết các khối lượng công việc động và đa dạng của LLM, có thể khác nhau rất nhiều về nhu cầu tính toán của chúng. Phân tích cú pháp đang bay tối ưu hóa việc lên lịch các tác vụ này, đảm bảo rằng các tài nguyên GPU được sử dụng tối đa. Kết quả là, các yêu cầu LLM thực tế trên GPU Tensor Core H100 thấy tăng gấp đôi thông lượng, dẫn đến các quy trình suy luận AI nhanh hơn và hiệu quả hơn.

Nvidia cho biết TensorRT-LL của họ tích hợp trình biên dịch học sâu với các kernel được tối ưu hóa, các bước xử lý trước và sau, và các nguyên thủy giao tiếp đa GPU/đa nút, đảm bảo chúng chạy hiệu quả hơn trên GPU của họ. Sự tích hợp này được bổ sung thêm bởi API Python mô-đun, cung cấp giao diện thân thiện với nhà phát triển để tăng cường thêm khả năng của phần mềm và phần cứng mà không cần đi sâu vào các ngôn ngữ lập trình phức tạp. Ví dụ, MosaicML đã thêm các tính năng cụ thể mà họ cần trên TensorRT-LL một cách liền mạch và tích hợp chúng vào dịch vụ suy luận của họ.

"TensorRT-LLM dễ sử dụng, tích hợp nhiều tính năng như streaming của token, phân tích cú pháp đang bay, chú ý theo trang, lượng tử hóa, v.v., và hiệu quả", Naveen Rao, phó chủ tịch kỹ thuật của Databricks cho biết. "Nó cung cấp hiệu suất hàng đầu cho việc phục vụ LLM bằng cách sử dụng GPU NVIDIA và cho phép chúng tôi chuyển chi phí tiết kiệm cho khách hàng của chúng tôi."

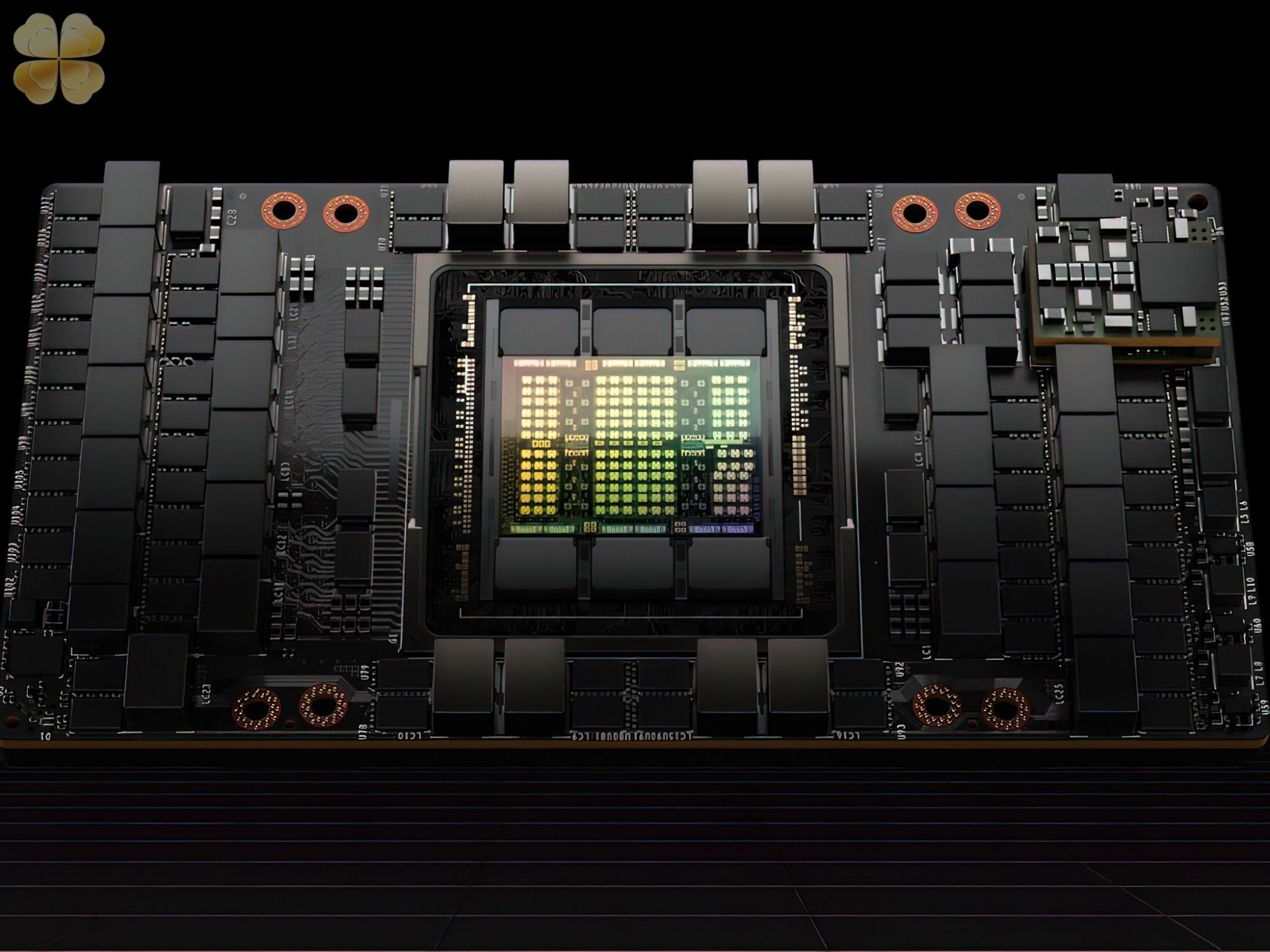

Hiệu suất của H100 của Nvidia khi được kết hợp với TensorRT-LLM rất ấn tượng. Trên kiến trúc Hopper của NVIDIA, GPU H100, khi được ghép nối với TensorRT-LLM, vượt trội hơn GPU A100 gấp tám lần. Hơn nữa, khi thử nghiệm mô hình Llama 2 do Meta phát triển, TensorRT-LLM đã đạt được khả năng tăng tốc 4,6 lần về hiệu suất suy luận so với GPU A100. Các con số này nhấn mạnh tiềm năng biến đổi của phần mềm trong lĩnh vực AI và học máy.

Cuối cùng, GPU H100, khi được sử dụng cùng với TensorRT-LLM, hỗ trợ định dạng FP8. Khả năng này cho phép giảm thiểu việc tiêu thụ bộ nhớ mà không làm mất độ chính xác của mô hình, có lợi cho các doanh nghiệp có ngân sách hạn chế và/hoặc không gian trung tâm dữ liệu và không thể cài đặt số lượng máy chủ đủ để điều chỉnh LLM của họ.

© newsliver.com. All Rights Reserved.