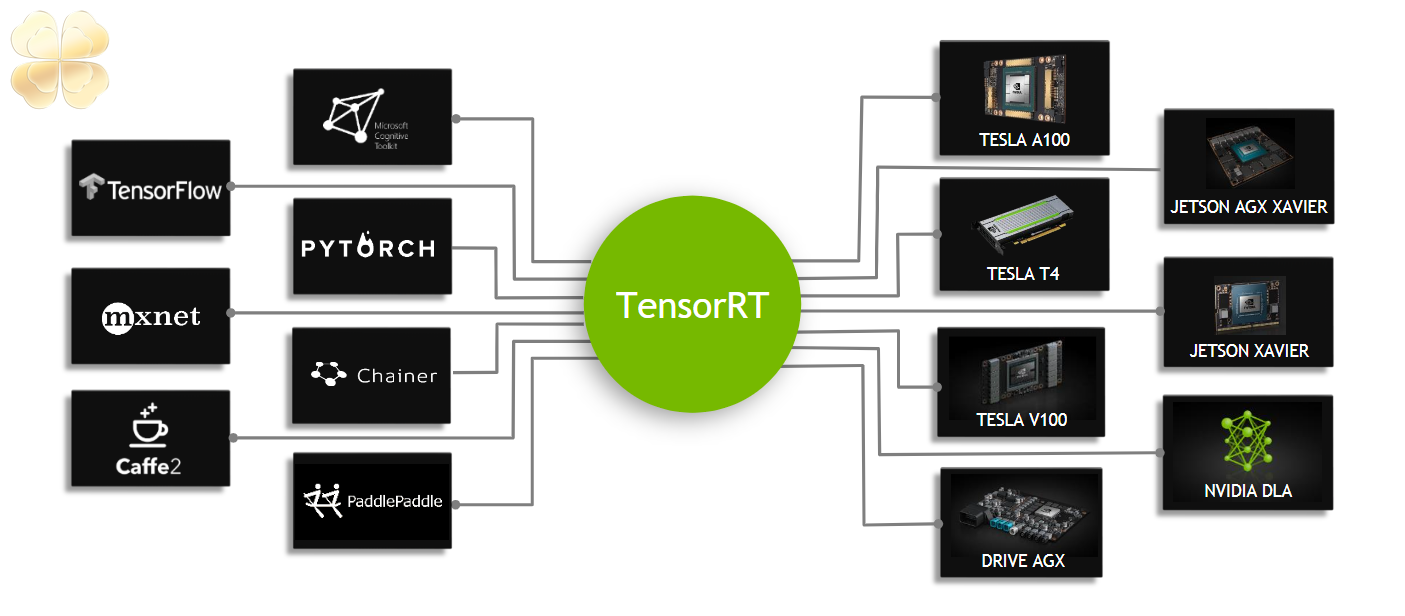

NVIDIA đã và đang nỗ lực cải tiến bộ công cụ AI/ML (trí tuệ nhân tạo/học máy) và LLM (mô hình ngôn ngữ lớn) của mình. Bổ sung mới nhất là TensorRT và TensorRT-LLM, được thiết kế để tối ưu hóa hiệu suất của GPU tiêu dùng và nhiều card đồ họa tốt nhất để chạy các tác vụ như Stable Diffusion và tạo văn bản Llama 2. Chúng tôi đã thử nghiệm một số GPU mới nhất của NVIDIA bằng TensorRT và nhận thấy hiệu suất trong Stable Diffusion được cải thiện tới 70%. TensorRT hiện có sẵn để tải xuống tại trang GitHub của NVIDIA, mặc dù chúng tôi đã có quyền truy cập sớm cho mục đích của cái nhìn ban đầu này.

Chúng tôi đã thấy rất nhiều chuyển động trong Stable Diffusion trong khoảng một năm trở lại đây. Cái nhìn đầu tiên của chúng tôi đã sử dụng WebUI của automatic1111, ban đầu chỉ hỗ trợ GPU NVIDIA trong Windows. Kể từ đó, số lượng các công cụ tạo văn bản thành hình ảnh thay thế và các nhánh thay thế đã bùng nổ, cả AMD và Intel đều đã phát hành các thư viện được tinh chỉnh tốt hơn đã thu hẹp khoảng cách phần nào với hiệu suất của NVIDIA. Bạn có thể xem tổng hợp mới nhất của chúng tôi về điểm chuẩn Stable Diffusion trong các bài đánh giá AMD RX 7800 XT và RX 7700 XT của chúng tôi. Giờ đây, NVIDIA đã sẵn sàng nới rộng khoảng cách một lần nữa với TensorRT.

Ý tưởng cơ bản tương tự như những gì AMD và Intel đã làm. Tận dụng ONNX, một định dạng mở cho các mô hình và toán tử AI và ML, mô hình Stable Diffusion cơ bản của Hugging Face được chuyển đổi thành định dạng ONNX. Từ đó, bạn có thể tối ưu hóa thêm hiệu suất cho GPU cụ thể mà bạn đang sử dụng. TensorRT sẽ mất vài phút (hoặc đôi khi hơn) để điều chỉnh mọi thứ, nhưng sau khi hoàn tất, bạn sẽ nhận được một sự cải thiện đáng kể về hiệu suất cùng với việc sử dụng bộ nhớ tốt hơn.

Chúng tôi đã chạy tất cả các GPU RTX 40-series mới nhất của NVIDIA thông qua quy trình điều chỉnh (mỗi quy trình phải được thực hiện riêng để có hiệu suất tối ưu), cùng với việc kiểm tra hiệu suất Stable Diffusion cơ bản và hiệu suất sử dụng Xformers. Chúng tôi chưa hoàn toàn sẵn sàng để cập nhật đầy đủ so sánh hiệu suất của AMD, Intel và NVIDIA trong Stable Diffusion, vì chúng tôi đang thử nghiệm lại một loạt GPU bổ sung bằng cách sử dụng các công cụ được tối ưu hóa mới nhất, vì vậy cái nhìn ban đầu này chỉ tập trung vào GPU NVIDIA. Chúng tôi đã bao gồm một RTX 30-series (RTX 3090) và một RTX 20-series (RTX 2080 Ti) để cho thấy mức tăng TensorRT áp dụng cho tất cả dòng RTX của NVIDIA như thế nào.

Mỗi phòng trưng bày ở trên, ở 512x512 và 768x768, sử dụng các mô hình Stable Diffusion 1.5. Chúng tôi đã "quay lại" sử dụng 1.5 thay vì 2.1, vì cộng đồng người sáng tạo thường thích kết quả của 1.5 hơn, mặc dù kết quả sẽ gần giống với các mô hình mới hơn. Đối với mỗi GPU, chúng tôi đã chạy các kích thước lô và số lượng lô khác nhau để tìm thông lượng tối ưu, tạo ra tổng cộng 24 hình ảnh cho mỗi lần chạy. Sau đó, chúng tôi tính trung bình thông lượng của ba lần chạy riêng biệt để xác định tốc độ tổng thể, do đó tổng cộng 72 hình ảnh được tạo cho mỗi định dạng mô hình và GPU (không tính các lần chạy bị loại bỏ).

Các yếu tố khác nhau đóng vai trò trong thông lượng tổng thể. GPU tính toán khá nhiều, cũng như băng thông bộ nhớ. Dung lượng VRAM có xu hướng là một yếu tố ít hơn, ngoài việc có thể cho phép các mục tiêu độ phân giải hình ảnh hoặc kích thước lô lớn hơn - có những điều bạn có thể làm với 24GB VRAM mà không thể thực hiện được với 8GB, nói cách khác. Kích thước bộ nhớ đệm L2 cũng

© newsliver.com. All Rights Reserved.