Card đồ họa Nvidia RTX Blackwell: Không chỉ dành cho game thủ

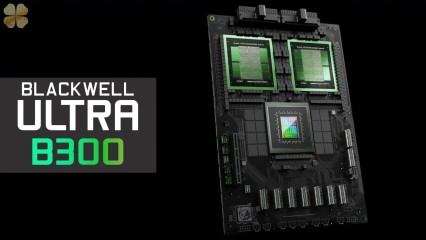

Card đồ họa Nvidia RTX Blackwell không chỉ dành riêng cho game thủ. Từ lâu, card đồ họa Nvidia đã hỗ trợ mạnh mẽ các tính năng chuyên nghiệp cho người sáng tạo nội dung, từ chỉnh sửa video, ảnh, dựng hình 3D cho đến âm thanh. Với kiến trúc Blackwell mới, nhiều tính năng tiên tiến sẽ được hỗ trợ bởi trí tuệ nhân tạo (AI).