Nvidia hôm nay đã công bố rằng họ đã đệ trình kết quả điểm chuẩn đầu tiên cho Superchip CPU + GPU Grace Hopper và bộ tăng tốc GPU L4 của họ cho phiên bản mới nhất của MLPerf, một điểm chuẩn AI tiêu chuẩn công nghiệp được thiết kế để cung cấp một sân chơi bình đẳng để đo lường hiệu suất AI trong các tác vụ khác nhau.

Kết quả điểm chuẩn vòng này đánh dấu hai điểm mới đáng chú ý cho điểm chuẩn MLPerf:

Nvidia cho biết Superchip Grace Hopper cung cấp hiệu suất suy luận cao hơn 17% so với một trong những GPU H100 hàng đầu của họ trong bài kiểm tra GPT-J và rằng GPU L4 của họ cung cấp hiệu suất cao hơn 6 lần so với CPU Xeon của Intel.

Ngành công nghiệp đang phát triển với tốc độ chóng mặt khi nó nhanh chóng phát triển thành các mô hình AI mới và các triển khai mạnh mẽ hơn. Cùng với đó, điểm chuẩn MLPerf, được quản lý bởi cơ quan MLCommons, liên tục phát triển để phản ánh tốt hơn bản chất thay đổi của cảnh quan AI với bản sửa đổi v3.1 mới của nó.

GPT-J 6B, một mô hình tổng hợp văn bản được sử dụng trong các tác vụ thực tế từ năm 2021, hiện được sử dụng trong bộ MLPerf như một điểm chuẩn để đo lường hiệu suất suy luận. LLM 6 tỷ tham số GPT-J khá nhẹ so với một số mô hình AI tiên tiến hơn, như GPT-3 175 tỷ tham số, nhưng nó phù hợp với vai trò của một điểm chuẩn suy luận một cách đẹp mắt. Mô hình này tóm tắt các khối văn bản và hoạt động ở cả chế độ trực tuyến, nhạy cảm với độ trễ và chế độ ngoại tuyến, tập trung vào thông lượng.

Bộ MLPerf cũng hiện đang sử dụng mô hình khuyến nghị DLRM-DCNv2 lớn hơn với số lượng tham số gấp đôi, tập dữ liệu đa nóng lớn hơn và thuật toán liên lớp tốt hơn đại diện cho môi trường thực tế.

Với nền tảng đó, chúng ta có thể thấy một số tuyên bố về hiệu suất của Nvidia ở đây. Lưu ý rằng Nvidia tự mình gửi các điểm chuẩn này cho MLCommons, vì vậy chúng có thể đại diện cho các trường hợp tối ưu nhất. Nvidia cũng thích chỉ ra rằng họ là công ty duy nhất gửi điểm chuẩn cho mọi mô hình AI được sử dụng trong bộ MLPerf, đây là một tuyên bố khách quan đúng. Một số công ty hoàn toàn vắng mặt, như AMD, hoặc chỉ gửi một số bài kiểm tra được chọn, như Intel với Habana và Google với TPU của họ. Lý do cho việc thiếu bài nộp khác nhau theo công ty, nhưng việc có nhiều đối thủ cạnh tranh hơn bước vào vòng MLPerf sẽ rất tuyệt.

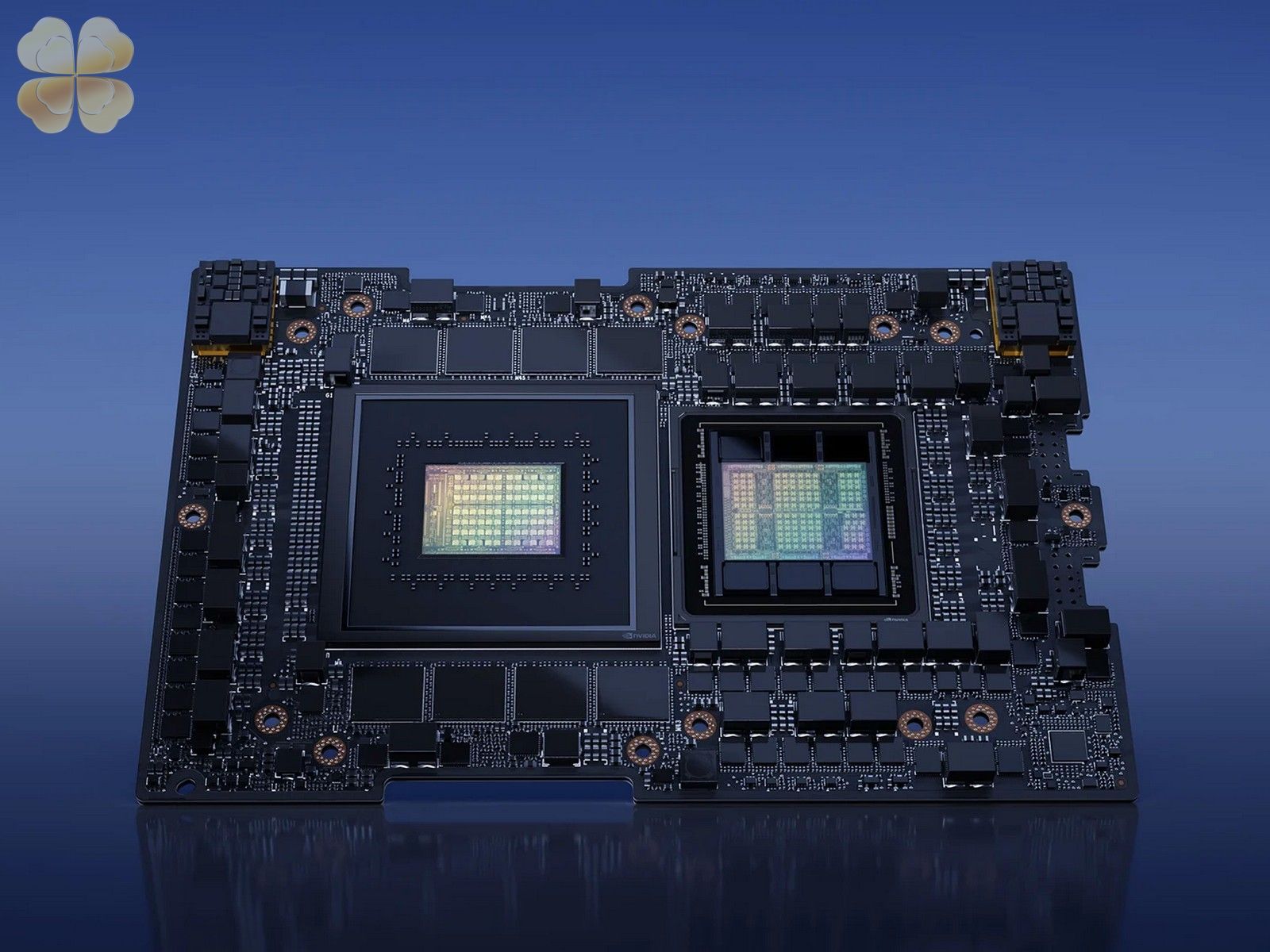

Nvidia đã gửi kết quả MLPerf đầu tiên của GH200 Grace Hopper Superchip, nhấn mạnh rằng combo CPU + GPU cung cấp hiệu suất cao hơn 17% so với một GPU H100 duy nhất. Trên bề mặt, điều đó thật đáng ngạc nhiên, vì GH200 sử dụng cùng silicon với CPU H100, nhưng chúng ta sẽ giải thích lý do tại sao bên dưới.

Tất nhiên, các hệ thống của Nvidia được trang bị tám H100 đã vượt qua Superchip Grace Hopper, dẫn đầu trong mọi bài kiểm tra suy luận.

Nhắc lại, Superchip Grace Hopper kết hợp GPU Hopper và CPU Grace trên cùng một bo mạch, cung cấp liên kết C2C (đắm mình sâu hơn ở đây) với 900GB/s thông lượng giữa hai đơn vị, do đó cung cấp 7 lần băng thông của kết nối PCIe tiêu chuẩn cho CPU-to-GPU truyền dữ liệu, tăng cường băng thông bộ nhớ có thể truy cập của GH200, được bổ sung bởi một nhóm nhớ đồng nhất bao gồm 96GB bộ nhớ HBM3 và băng thông bộ nhớ GPU 4TB/s. Ngược lại, H100 so sánh được kiểm tra trong HGX chỉ có 80GB HBM3 (các mẫu Grace Hopper thế hệ tiếp theo sẽ có 144GB HBM3e nhanh hơn 1,7 lần vào quý 2 năm 2024).

Nvidia cũng tự hào về công nghệ chuyển đổi điện động được gọi là Automatic Power Steering, tự động cân bằng ngân sách điện năng giữa CPU và GPU, chuyển ngân sách tràn sang đơn vị nào đang chịu nhiều tải

© newsliver.com. All Rights Reserved.