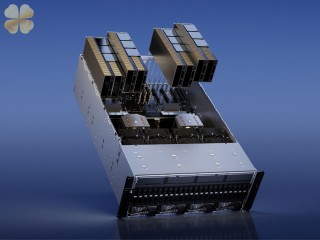

Mức tiêu thụ điện năng khổng lồ của các trung tâm dữ liệu AI

Nhu cầu về AI đang rất lớn hiện nay. Công ty Schneider Electric của Pháp ước tính rằng mức tiêu thụ điện năng của các khối lượng công việc AI sẽ đạt khoảng 4,3 GW vào năm 2023, thấp hơn một chút so với mức tiêu thụ điện năng của quốc gia Cyprus (4,7 GW) vào năm 2021. Công ty dự đoán rằng mức tiêu thụ điện năng của các khối lượng công việc AI sẽ tăng trưởng với tốc độ tăng trưởng kép hàng năm (CAGR) từ 26% đến 36%, điều này cho thấy rằng vào năm 2028, các khối lượng công việc AI sẽ tiêu thụ từ 13,5 GW đến 20 GW, nhiều hơn mức tiêu thụ của Iceland vào năm 2021.