AMD RX 7900 XTX Vượt Mặt RTX 4090 trong Thử Nghiệm AI, Hiệu Năng Ấn Tượng

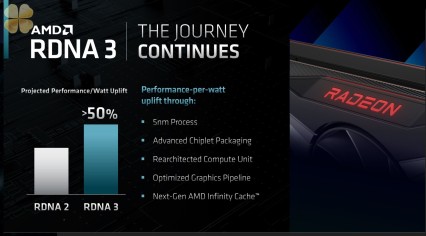

AMD vừa công bố kết quả thử nghiệm hiệu năng đáng chú ý của card đồ họa RX 7900 XTX, đối đầu trực tiếp với hai đối thủ nặng ký là NVIDIA RTX 4090 và RTX 4080 Super, trong một bài kiểm tra về khả năng xử lý mô hình trí tuệ nhân tạo (AI) DeepSeek. Theo chia sẻ từ chuyên gia David McAfee trên mạng xã hội X, card đồ họa RX 7900 XTX, được xây dựng trên kiến trúc RDNA3, đã thể hiện sức mạnh vượt trội, đánh bại RTX 4090 tới 13% và RTX 4080 Super tới 34% trong một số cấu hình thử nghiệm.