Nvidia đang lên kế hoạch tăng tốc phát triển các kiến trúc GPU mới và quay trở lại chu kỳ giới thiệu sản phẩm một năm một lần để duy trì vị thế dẫn đầu trong lĩnh vực trí tuệ nhân tạo (AI) và phần cứng tính năng cao (HPC).

Theo lộ trình được công bố cho các nhà đầu tư và được SemiAnalysis giải thích thêm, GPU Blackwell của Nvidia sẽ được ra mắt vào năm 2024 và sẽ được kế nhiệm bởi một kiến trúc mới vào năm 2025.

Trước khi Blackwell được ra mắt vào năm sau, Nvidia dự kiến sẽ tung ra nhiều sản phẩm mới dựa trên kiến trúc Hopper. Điều này bao gồm sản phẩm H200, có thể là một phiên bản được làm lại của H100 với hiệu suất cao hơn, cũng như GH200NVL, sẽ giải quyết việc đào tạo và suy luận trên các mô hình ngôn ngữ lớn với CPU dựa trên Arm và GPU dựa trên Hopper.

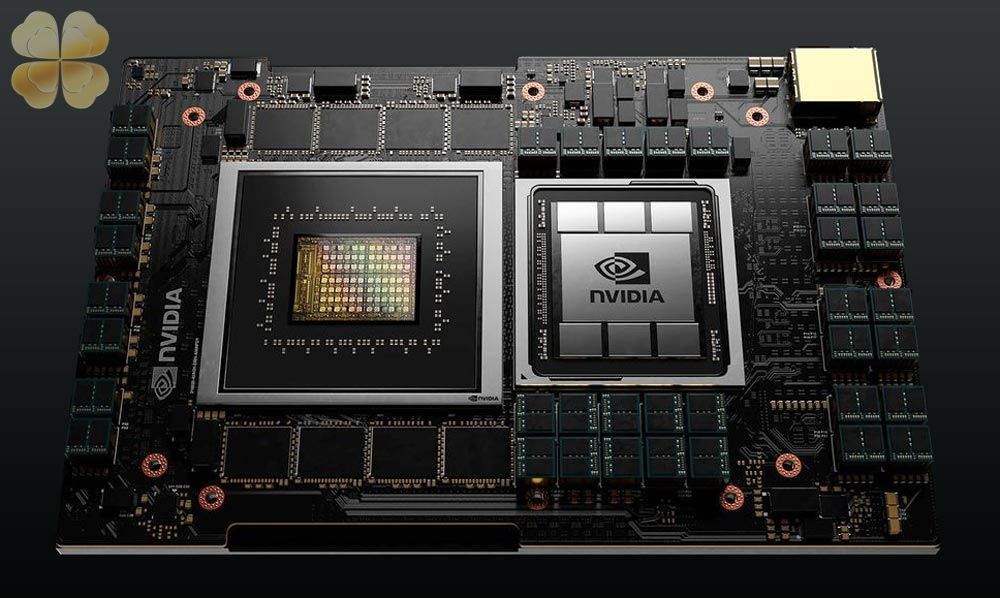

Đối với dòng sản phẩm Blackwell dự kiến ra mắt vào năm 2024, Nvidia dường như đang chuẩn bị sản phẩm B100 cho hoạt động tính toán AI và HPC trên nền tảng x86, sẽ kế nhiệm H100. Ngoài ra, công ty cũng đang chuẩn bị GB200, có thể là mô-đun Grace Hopper có CPU Arm và GPU Hopper, nhắm mục tiêu suy luận cũng như GB200NVL, một giải pháp dựa trên Arm cho việc đào tạo và suy luận LLM. Công ty cũng đang lên kế hoạch sản phẩm B40, có thể là một giải pháp dựa trên GPU máy khách cho suy luận AI.

Vào năm 2025, Blackwell sẽ được kế nhiệm bởi một kiến trúc được ký hiệu bằng chữ X, có thể chỉ là một vị trí dành chỗ hiện tại. Tuy nhiên, Nvidia đang chuẩn bị X100 cho đào tạo và suy luận AI x86 cũng như HPC, GX200 cho suy luận Arm (CPU Grace + GPU X) và GX200NVL cho đào tạo và suy luận LLM dựa trên Arm. Ngoài ra, sẽ có sản phẩm X40 - có thể dựa trên giải pháp dựa trên GPU máy khách - cho suy luận chi phí thấp hơn.

Hiện tại, Nvidia đang dẫn đầu thị trường GPU AI, nhưng AWS, Google, Microsoft cũng như các nhà cung cấp AI và HPC truyền thống như AMD và Nvidia đều đang chuẩn bị các bộ xử lý thế hệ mới của họ cho việc đào tạo và suy luận. Đây là lý do tại sao Nvidia được cho là đã đẩy nhanh kế hoạch của mình đối với các sản phẩm dựa trên B100 và X100.

Để củng cố thêm vị thế của mình, Nvidia được cho là đã mua trước năng lực của TSMC và bộ nhớ HBM từ cả ba nhà sản xuất. Ngoài ra, công ty đang đẩy mạnh các máy chủ HGX và MGX của mình trong nỗ lực biến những chiếc máy này trở thành hàng hóa và phổ biến với người dùng cuối, đặc biệt là trong phân khúc AI doanh nghiệp.

Nvidia tăng tốc phát triển GPU mới để duy trì vị thế dẫn đầu trong AI và HPC là một tin tốt cho ngành công nghiệp công nghệ nói chung và cho người dùng AI và HPC nói riêng. Điều này sẽ dẫn đến sự cạnh tranh gay gắt hơn giữa các nhà cung cấp GPU, mang lại lợi ích cho người dùng dưới dạng sản phẩm tốt hơn và giá cả phải chăng hơn.

© newsliver.com. All Rights Reserved.