Samsung đối mặt thách thức khổng lồ, lợi nhuận dự kiến giảm mạnh năm 2025

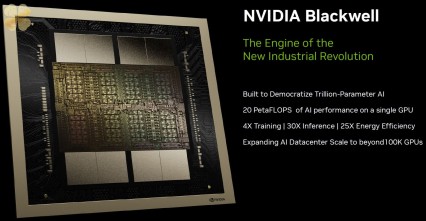

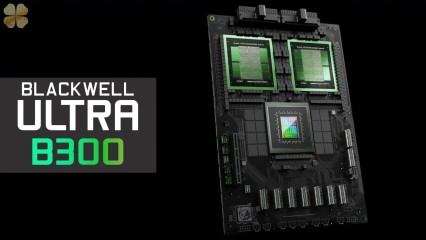

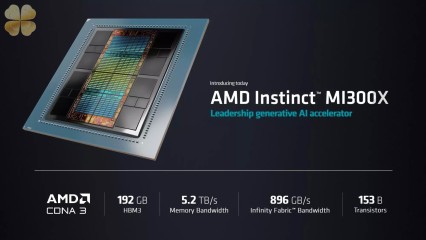

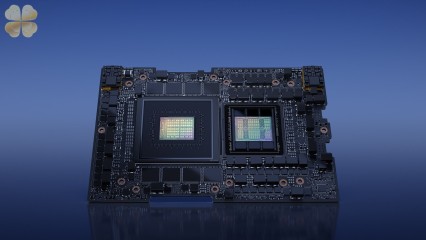

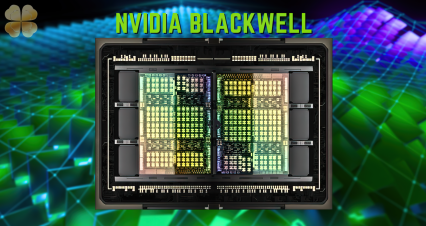

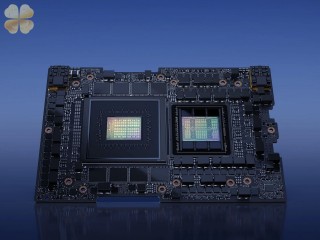

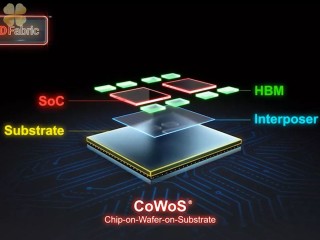

Samsung đang đối mặt với một năm 2025 đầy thách thức. Theo báo Chosun Daily, lợi nhuận hoạt động của hãng dự kiến giảm mạnh, chỉ còn khoảng 30 tỷ USD, giảm hơn một nửa so với dự báo trước đó. Nguyên nhân chính đến từ nhiều vấn đề chồng chéo. Thị trường chip AI đang bùng nổ, nhưng Samsung lại tụt hậu so với đối thủ TSMC, đặc biệt trong lĩnh vực bộ nhớ băng thông cao (HBM). Việc sản xuất công nghệ 3nm GAA cũng gặp khó khăn, dẫn đến việc mất đơn hàng lớn từ Qualcomm cho Snapdragon 8 Elite Gen 2. Thêm vào đó, áp lực cạnh tranh từ các nhà sản xuất Trung Quốc trong thị trường DRAM cũng rất lớn. Thậm chí, nếu ông Donald Trump tái đắc cử tổng thống Mỹ, chính sách thuế quan có thể khiến giá chip nhớ của Samsung tăng, gây ảnh hưởng đến nhu cầu điện thoại thông minh và các thiết bị điện tử khác. Mục tiêu sản lượng điện thoại năm 2025 cũng được điều chỉnh giảm 8 triệu máy. Tóm lại, Samsung cần có chiến lược rõ ràng và hành động quyết liệt trong 12 tháng tới để tránh tình trạng lợi nhuận tiếp tục giảm sút. Tương lai của gã khổng lồ công nghệ Hàn Quốc đang đứng trước ngã ba đường.