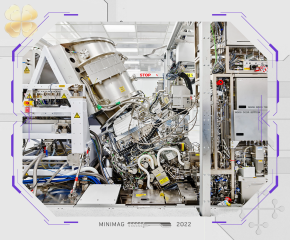

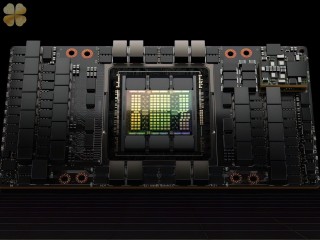

Nga phát triển tổ hợp in thạch bản nội địa để sản xuất chip không cần mặt nạ

Các nhà nghiên cứu từ Đại học Bách khoa St. Petersburg (SPbPU) đã phát triển một tổ hợp in thạch bản nội địa để sản xuất chip không cần mặt nạ sử dụng phương pháp khắc, một bước tiến quan trọng hướng tới việc tự chủ về vi điện tử của Nga, theo CNews, dẫn lời RIA Novosti của nhà nước. Một trong những công cụ có giá năm triệu rúp (49.5 nghìn đô la), giá của một chiếc ô tô hiện đại, và chi phí của một công cụ khác không được tiết lộ.